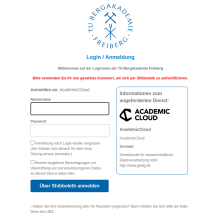

Anmeldung

Sie können sich über die AcademicCloud oder direkt über diesen Link einfach per SSO einloggen.

Klicken Sie auf "Föderierte Anmeldung" und wählen "TU Bergakademie Freiberg" aus.

Es folgt die Shibboleth-Abfrage. Geben Sie hier Ihre zentralen Nutzerdaten ein.

Sie können nun mit der generativen KI chatten.

Oberfläche und Bedienung

Die Oberfläche ist intuitiv gestaltet, so dass Sie einfach navigieren und den Chatbot effizient nutzen können.

Sie haben die Wahl und können mit der KI per Nachricht, per Textdatei oder per Voice-Eingabe chatten.

Rechts neben dem Chatfenster können Sie zwischen den verschiedenen KI-Modellen wählen:

- Meta Llama 3.1 8B Instuct

- InternVL2 8B

- Meta Llama 3.3 70B Instruct

- Meta Llama 3.1 70B Instruct

- Llama 3.1 Nemotron 70B Instruct

- Llama 3.1 SauerkrautLM 70B Instruct

- Mistral Large Instruct

- Qwen 2.5 72B Instruct

- Codestral 22B

- Teuken 7B Instruct Research

Darunter haben Sie noch weitere Optionen, um Ihren Workflow anpassen zu können, z.B. den System-Prompt oder die Temperatur für die Kreativität und Zufälligkeit des Modells).

Verfügbare Modelle und ihre Einsatzgebiete

Quelle: https://docs.hpc.gwdg.de/services/chat-ai/models/index.html (Stand 09.01.2025)

| Modellname | Entwickler | Betriebssystem | Wissensabschaltung | Kontextfenster | Vorteile | Mögliche Konfiguration für Vorteile |

|---|---|---|---|---|---|---|

| Llama 3.1 8B Instruct | Meta | ja | Dezember 2023 | 128.000 Token | Schnellste allgemeine Verwendung | Standard (Temp: 0,5; top_P: 0,5) |

| Llama 3.1 70B Instruct | Meta | ja | Dezember 2023 | 128.000 Token | Tolle Gesamtleistung Mehrsprachiges Denken und kreatives Schreiben | Standard Temp: 0,7; top_P: 0,8 |

| Llama 3.1 SauerkrautLM 70B Instruct | VAGOsolutions x Meta | ja | Dezember 2023 | 128.000 Token | Deutsche Gesamtnutzung | Standard |

| Llama 3.1 Nemotron 70B Instruct | NVIDIA x Meta | ja | Dezember 2023 | 128.000 Token | Gesamtverbesserungen gegenüber Llama 3.1 70B | Standard |

| Mistral Large Instruct | Mistral | ja | Juli 2024 | 128.000 Token | Tolle Gesamtleistung Codierung und mehrsprachiges Denken | Standard |

| Codestral 22B Instruct | Mistral | ja | Ende 2021 | 33.000 Token | Code schreiben, bearbeiten, reparieren und kommentieren Sondierungsprogrammierung | Temp: 0,2; top_P: 0,1 Temp: 0,6; top_P: 0,7 |

| E5 Mistral 7B Instruct | Infloat x Mistral | ja | - - | 4096 Token | Einbettungen, nur API | - - |

| Qwen 2.5 72B Instruct | Alibaba Cloud | ja | September 2024 | 128.000 Token | Globale Angelegenheiten, Chinesisch, allgemeine Nutzung. Mathematik, Logik | Standard Temp: 0,2; top_P: 0,1 |

| Qwen 2 VL 72B Instruct | Alibaba Cloud | ja | Juni 2023 | 32.000 Token | VLM, chinesische Gesamtnutzung | Standard |

| InternVL2 8B | OpenGVLab | ja | September 2021 | 32.000 Token | VLM, klein und schnell | Standard |